Модульный ЦОД на службе у большого адронного коллайдера

Узнаем про дата-центр, который обслуживает один из главных научных объектов планеты.

Последних лет двадцать дата-центры появляются как грибы после дождя, оно и понятно. Кроме количественных показателей развиваются и качественные — новые формы, новые подходы к построению среды. Одним из таких новшеств стали модульные ЦОДы. Эффективность решений на базе стандартизированного контейнера впервые смогли оценить военные, именно они стали пионерами в использовании дата-центров построенных по модульному принципу.

ЦОД большого адронного коллайдера

- Контейнер — все гениальное просто!

- CERN выбирает модульный ЦОД

- Жизнь после Хиггса

Быстрое разворачивание вычислительных мощностей и возможность хранения данных в самых отдаленных уголках Земли стали для военных панацеей в мире с ежедневно нарастающим объемом генерируемой информации. Благодаря компании Sun Microsystems, уже в 2006 году модульные дата-центры стали доступными и для гражданских потребителей. Но казалось бы, кто их будет приобретать?

В условиях жестокой борьбы участников ИТ-рынка за высокую производительность «железа» плюсы от модульности ЦОДов, в большинстве случаев гражданской жизни, нещадно перечеркиваются целым спектром минусов порождаемых этой самой модульностью. Но как показало время — не все так однозначно в этой теме и продукт нашел своего потребителя.

Одним из таких потребителей, как бы это не было удивительно, стал CERN. Детище организации — большой адронный коллайдер, обрастет парой новых модульных дата-центров. Весьма странное решение? Об этом и не только пойдет далее речь.

Контейнер — все гениальное просто!

На сколько известно впервые эту идею с контейнером реализовали военные — напичкать металлический каркас серверными стойками, интегрировать в него систему охлаждения и вот вам готовое решение. Но при всей утилитарности такого дата-контейнера возникают вопросы гибкости, эффективности функционирования его начинки.

На сколько установленное стандартное железо соответствует выполняемым задачам, ведь задел персонализации серверных стоек там весьма ограничен. С одной стороны формфактор контейнера не дает развернутся в нем, как в прямом так и переносном смысле, сетевому администратору. С другой стороны замена начинки на более мощную может банально вывести из строя вспомогательные системы контейнера: энергообеспечение, охлаждение.

Даже имея возможность легкого наращивания мощностей своей серверной конструкции, методом доставки еще и еще одного контейнера, проблема повышения эффективности работы конкретной стойки в модуле не решается ни как, а это сильно ограничивает область применения такой конструкции.

CERN выбирает модульный ЦОД

«До конца 2019 года мы планируем установить два новых дата-центра, каждый из которых будет обслуживать исключительно свой детектор БАК. Детектор относящийся к эксперименту LHCb удостоится шести модулей, детектор эксперимента ALISA будет обслуживать дата-центр из четырех контейнеров.

Необходимость в расширении существующей инфраструктуры была вызвана модернизацией упомянутых детекторов. После модернизации количество генерируемых детекторами данных возрастет в разы»- заявил заместитель руководителя одного из проектов CERN — Нико Ньюфилд (Niko Neufeld)

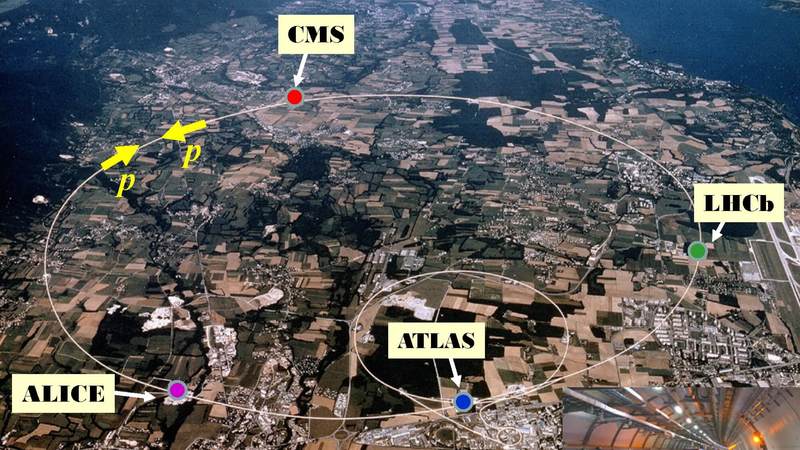

БАК(Большой адронный коллайдер) — проект под эгидой CERN, это колоссальная структура, что разместилась на глубине около 100 метров в самом сердце Западной Европы, на территории двух государств — Франции и Швейцарии. Имея диаметр в 8,5 км и протяженность около 27 км БАК сложно упрекнуть в удаленности от цивилизации.

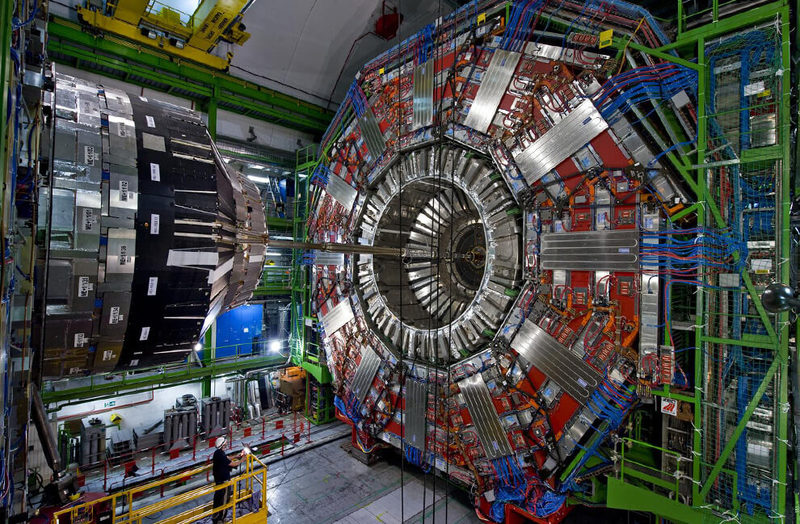

Сам проект по сути является ядром современной науки, двигателем ее фундаментальной составной. Кроме того существующая ИТ-инфраструктура обслуживающая БАК отвечает всем современным стандартам, включая в себя дата-центры и оптико-волоконные магистрали, которые объединяют его со всем миром. Какой был смысл в решении европейских ядерщиков из CERN наращивать мощности ИТ-инфраструктуры посредством модульных дата-центров?

На данный момент непосредственно нужды коллайдера обслуживает аж пять дата-центров. Из них четыре закрепленные за четырьмя главными датчиками каждого из основных экспериментов: ATLAS, CMS, ALISA и LHCb. Пятый дата-центр наибольший — является центральный узлом по обработке и хранению данных собранных со всего научного комплекса БАК.

«В данный момент центральный детектор обслуживающий эксперимент LHCb фиксирует происходящие в нем события с частотой в 1 МГц, после модернизации частота фиксации возрастет в 40 раз, а это представте себе 40 000 000 записей в секунду» -продолжил Нико.

Оно и не удивительно, что новое время потребовало новое оборудование. Увеличение потока данных это повсеместная тенденция и удивляться модернизации сетевой инфраструктуры нечего, но почему именно модульные дата-центры? Ответ не заставил себя долго ждать.

«Это чистая экономия. Специфика работы детекторов состоит в краткосрочных, объемных всплесках генерации данных. Объем данных порожденный этими всплесками известен с весьма высокой точностью, по этому мы точно знаем сколько дискового пространства для хранения данных нам нужно и этот объем будет актуален до крайней фазы проведения эксперимента.

Более того, разместив серверные-модули как можно ближе к датчикам, мы сократили длину оптико-волоконных коммуникаций необходимых для передачи 30 ПБайт данных за короткий промежуток времени, цена прокладки таких коммуникаций весьма внушительна. » — пояснил Нико.

Согласно обрисованной сотрудником CERN схеме ситуация с выбором инфраструктуры стала проясняться. Генерируемые датчиками БАК огромный поток данных будет за самое короткое время попадать на первичные центры обработки и хранения данных, после чего, в ожидании следующего запуска датчика, собранная информация будет постепенно перетекать в центральный ЦОД, не слишком перегружая существующую сетевую инфраструктуру.

Жизнь после Хиггса

Фактически вся эта мегалитическая структура — БАК, создавалась с целью выявить/опровергнуть существование базона Хиггса. В 2013 году косвенные признаки существования были обнаружены и первоначальная задача была решена.

Полтора года простоя коллайдера потребовались сотрудникам CERN что бы провести модернизацию существующих детекторов, которые смогли бы решать уже новые задачи. Однако прошло не более трех лет с даты нового запуска и в данный момент БАК ожидает очередная модернизация, отключение коллайдера должно продлиться с 2019 по 2021 год.

Как мы видим тут складывается ситуация, что обременять проект тяжелой, стационарной инфраструктурой не имеет смысла, ведь после короткой стадии сбора статистических данных весьма высоки шансы, что надобность в ней просто отпадет.

Как показывает практика новые проекты все равно потребуют новой инфраструктуры, иного оборудования задействованного в ней. Установленные же сейчас модули можна будет всегда легко переместить в другое место, где их использование будет более рационально.

«Сейчас датчик от проекта LHDb обслуживает серверная размещенная непосредственно возле него — под землей. Модернизировать эту площадку нам помешали два фактора: ограниченное подземельем пространство и проблемы вызванные невозможностью эффективного охлаждения серверной » — заметил Нико.

Существующая серверная, о которой упомянул сотрудник научного центра, находится на глубине 100 метров, в моменты пиковой нагрузки на серверы количество выделяемого ими тепла порождает необходимость в доставке нагретой охлаждающей жидкости на поверхность, где она может отдать лишнее тепло в атмосферу после чего снова возвращается в низ.

Больших затрат на охлаждение серверов в модулях явно не предвидится. Учитывая прохладный климат альпийского предгорья, PUE — коэффициент эффективности системы охлаждения составит менее 1.1 (лишь 10% энергии от потребляемой серверным оборудованием будет уходить на его охлаждение).

До марта месяца 2019 года все десять модулей должны будут занять свои проектные места. Ближе к концу года к дата-центрам будут подведены оптико-волоконные линии, лишь после этого инфраструктура будет функциональной. Однако проявить себя в деле она сможет не ранее чем через три года. Первый запуск большего адронного коллайдера, после проведения модернизации, запланирован аж на 2021.

«Но самое может быть необычное в наших новых дата-центрах это то, что мы не будем для них обеспечивать резервный источник питания. За 6 лет работы в научном центре у нас ни разу не случалось аварийных отключений электропитания» — подытожил Нико Ньюфилд. опубликовано econet.ru

Подписывайтесь на наш канал Яндекс Дзен!

Если у вас возникли вопросы по этой теме, задайте их специалистам и читателям нашего проекта здесь.

P.S. И помните, всего лишь изменяя свое потребление - мы вместе изменяем мир! © econet

Источник: https://econet.ru/

Понравилась статья? Напишите свое мнение в комментариях.

Добавить комментарий